研究面: LocalLLM システムの要素技術を中心に進めている。 経緯としては、去年の画像判別向けの multimodal LLM の検討では、 supervised learning に匹敵する性能が観測できず、その方向性での検討を pending していたが、 test-time-computing や prompt-optimization のアイデアが登場し、再度 LLM as edge AI が面白いなと思ったから。 具体的な検討としては、test-time-computing は lab の thesis reading group の中心トピックのため、 ピックアップされた論文を読んだり、lab mate の解説を聴いたりして理解を深めている。 ただ、OpenAI O1 が実装技術を秘匿したため、宝探し的に test-time-computing として大量の方法が提案されており、 これがベストで唯一の方法というのはない感じ。model 自体が test-time-computing というか deep-reasoning するように既に training されているものもあれば、追加モジュールを実装して、output の verification と refinement を進めていくものもある。 prompt-optimization に関しては、自分が特に面白そうと感じているのが、 data-driven optimization で、それぞれ prompt-template と demonstration (few-shot example) の最適化の手法の理解を深めている。 (OPRO, MIPRO, TextGrad, DSPy, etc.)。ただ懸念点があって、O1 や R1 のような deep-reasoning 系のモデルでは、 最適な prompt がそれ以前のパラダイムと大きく異なる(シンプルな方がいい)という話があり、調査中。 prompt-optimization は LocalLLM に限らず世間でも盛り上がり始めた agent の開発にも重要で、 chat application のように常に可変の one-time use の prompt と違って、 agent では変数以外は固定の prompt-template が利用されるため、性能に大きく効いてくる。 その他 offline-first システム向けの DB として、Turso や Electric SQL を触ってみていたり。

生活面: 環境を最大活用して、友人との交流を大切にしている。 1/20 の US president inauguration から、すごいスピード感で executive order が出されている。 mass deportation が始まって、米国向けの Google Maps は Gulf of Mexico を Gulf of America に表記変更するようだし、嘘みたいなことがホントに起きている。 直近では Deepseek が話題だ。CS 界隈で注目されているのはもちろん、別領域の友人からも質問を受けたりする。 中国人の友人によると、social media で一部の人が nationalism を高揚させているようで(China is #1 的な)よく思わないと言っていた。(*彼は中国の独裁政治を hate している)。 あとは、LA の wildfire のニュースにあるように Bay Area も去年に比べて雨が全然降らない。 他には卵不足で近所の Trader Joe's には卵がなくて、この前 Safeway で見つけたときは、 1 パック(12 個)10 ドルもするので困っている(鳥インフルエンザで 1 億羽以上が殺処分のためだそう)。

1. Research

Tue: Thesis Reading Group @Lab

bi-Thu: Lunch Meeting @Lab

# AI Meetup

1/16 Tooluse @AmazonSF

1/23 Fullstack OSS AI @AmazonSF

1/28 LLMOps @GoogleHQdata-driven prompt optimization、test-time-computing(agentic refining)を研究している。

地の利を活かして、参加費無料の AI meetup にいくつか参加して、情報収集と人脈作りをした。 現状 Vercel の AI SDK で足りているが、Toolhouse: AI agent 構築の managed service は built-in の tool が豊富で便利そうなので watch していきたい。 fullstack OSS AI は、OSS LLM の self-host で性能を出すための tips が中心で、GPU 実装などの core な内容で academic な面で参考になった。

Deepseek

- 中国のスタートアップが非常に低コストで高性能な LLM を実現したとして注目されている。

- V3 は、KV Caching や MoE などを導入して効率性を大きく向上させた LLM の base-model。

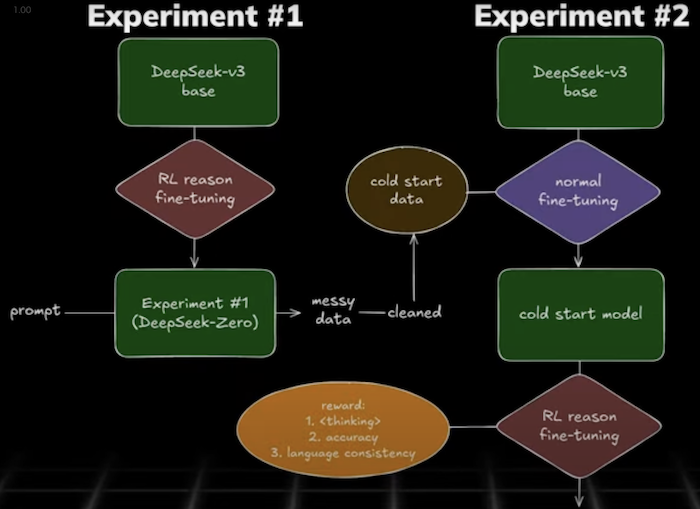

- V3 を GTPO という RL の方法で deep-reasoning できるように tuning した R1-zero が界隈ではすでに話題だった。

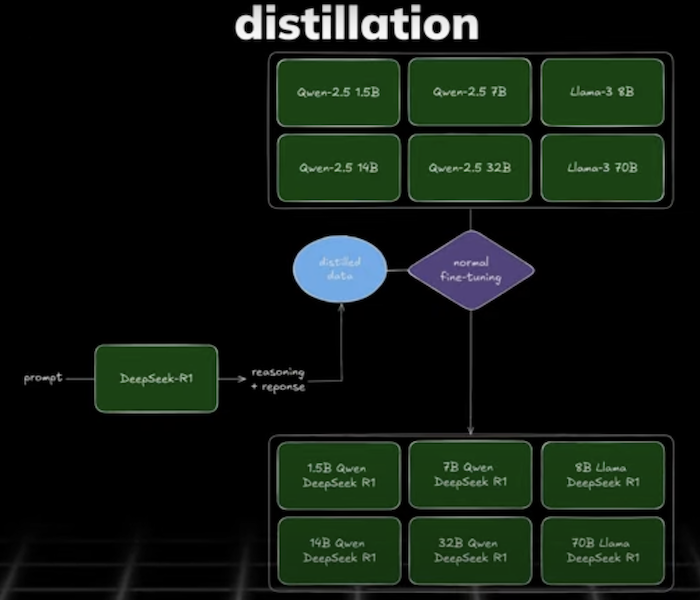

- 直近の R1 は、R1-zero の出力を manual refine したもので V3 を SFT して、更に RL し直すことで deep-reasoning 出力の可読性を上げたモデルでバズった。モデルアーキテクチャと重みは OSS になっているが、学習コードは非公開で、open-community でのより深い解析が進められている。watch して理解を深めていく予定。

- なお market は大騒ぎだが NVIDIA GPU への投資は減退しないというのが今の所の界隈の見立て。

- TinyZero: open r1-zero

- open-r1 *既に大量の star

- Dario の general な解説

その他

CES 2025 で興味深かったリリース

- NVIDIA Physical AI, AI Cosmos Platform

- NVIDIA AI Blueprints: Customizable reference applications speeding development of agentic and generative AI

- NVIDIA Project DIGITS: A powerful desktop AI supercomputer for $3,000

illuminate が便利

- notebook LLM での podcast 生成は有名だが、arxiv 論文読むのに illuminate がとても便利

- 深く読んだり、輪読会の始まる前に digest podcast を聴いておくのが自分の routine になっている

2. Life

1/1 Sushi Party

1/4 DeYoung Museum, Presidio

1/12 Hike & Costco

1/20 BBQ Party

1/26 Monterey Aquarium

# Stanford Event

1/11 Volleyball Match

1/15 MLK Celebration

1/15 Political Union Seminar

1/18 Gymnastics Match

1/19 Wrestling Match

1/22 Seminar "Where is God in Gaze"

1/24 Global Chef DinnerTom の握った sushi は本格的でとてもおいしかった。

3 度目の Monterey は、aquarium に行ってきた(本来 $65 するチケットを marine researcher の友人に貰ったので)。 world best aquarium とか言われているが、自分にとっては so-so だった。むしろ Cannery Row の歴史面の方が面白い。 (右の写真は AmazonSF で知り合った Yemen 出身のエンジニアと。)

Stanford のイベントに積極的に参加して、環境を最大活用している。 sports club team はプロレベルで特に gymnastics は見応えがあった。